Miles de opiniones se publican cada día en Google Maps, pero pocas veces se cuestiona quién las publica y cómo se decide cuáles se muestran y cuáles desaparecen.

Detrás de esa selección operan sistemas automatizados que no siempre distinguen entre una crítica legítima y un ataque organizado. En los últimos días, lo ocurrido con un negocio de restauración en Vigo ha expuesto las grietas de este modelo.

Mimassa era, hasta hace poco, uno de los restaurantes mejor valorados de la ciudad olívica, con una puntuación estable de 4,7 estrellas en Google Maps. Su cocina italiana tradicional y la autenticidad de sus preparaciones, junto con la atención cercana de su propietario, le valieron una clientela fiel y una crítica positiva constante.

Todo cambió el pasado 9 de julio de 2025, cuando el propietario libanés de este negocio, Samir Slim, expulsó de su terraza a un grupo de turistas israelíes. Según él, el grupo se comportó de forma agresiva desde el inicio, motivo por el que los invitó a abandonar el local sin cobrarles las consumiciones y en medio de reproches cruzados.

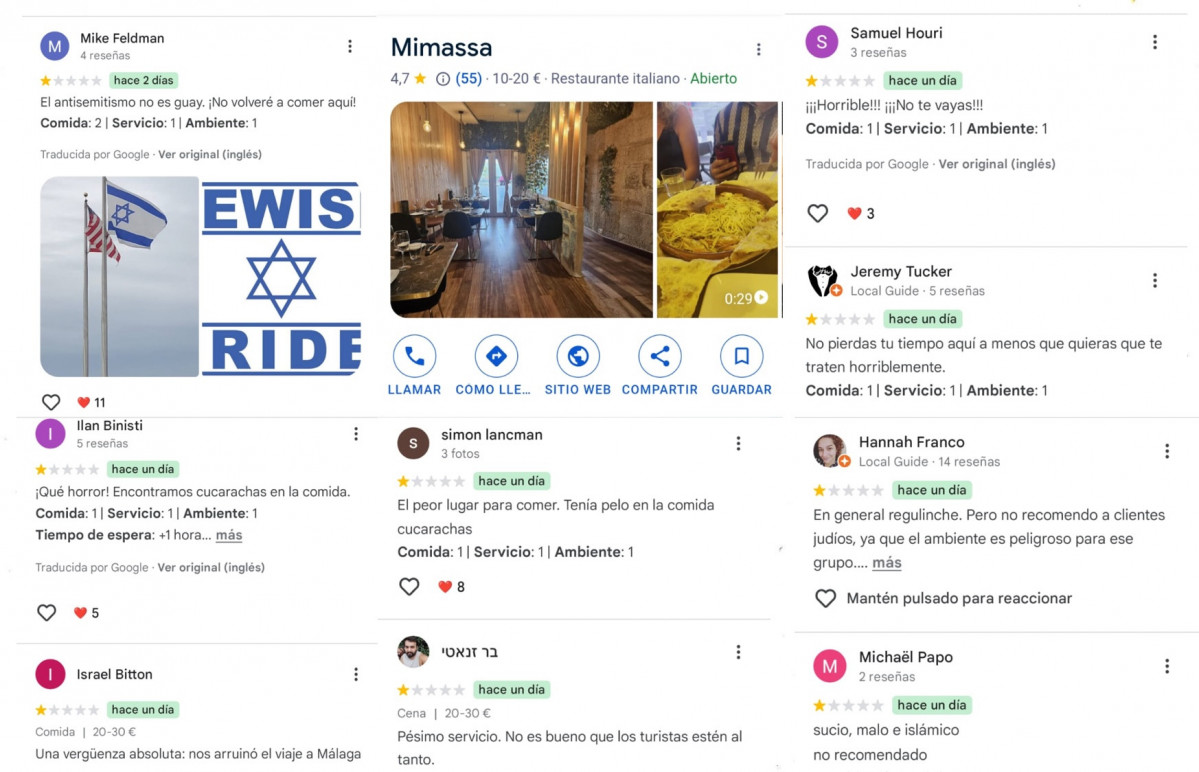

La grabación de este momento se hizo viral, hasta el punto de desatar una campaña digital en Google Maps en la que decenas de usuarios, muchos con perfiles recién creados y sin historial previo, comenzaron a publicar reseñas negativas y falsas que no tenían que ver con la calidad del restaurante, sino con acusaciones infundadas de antisemitismo.

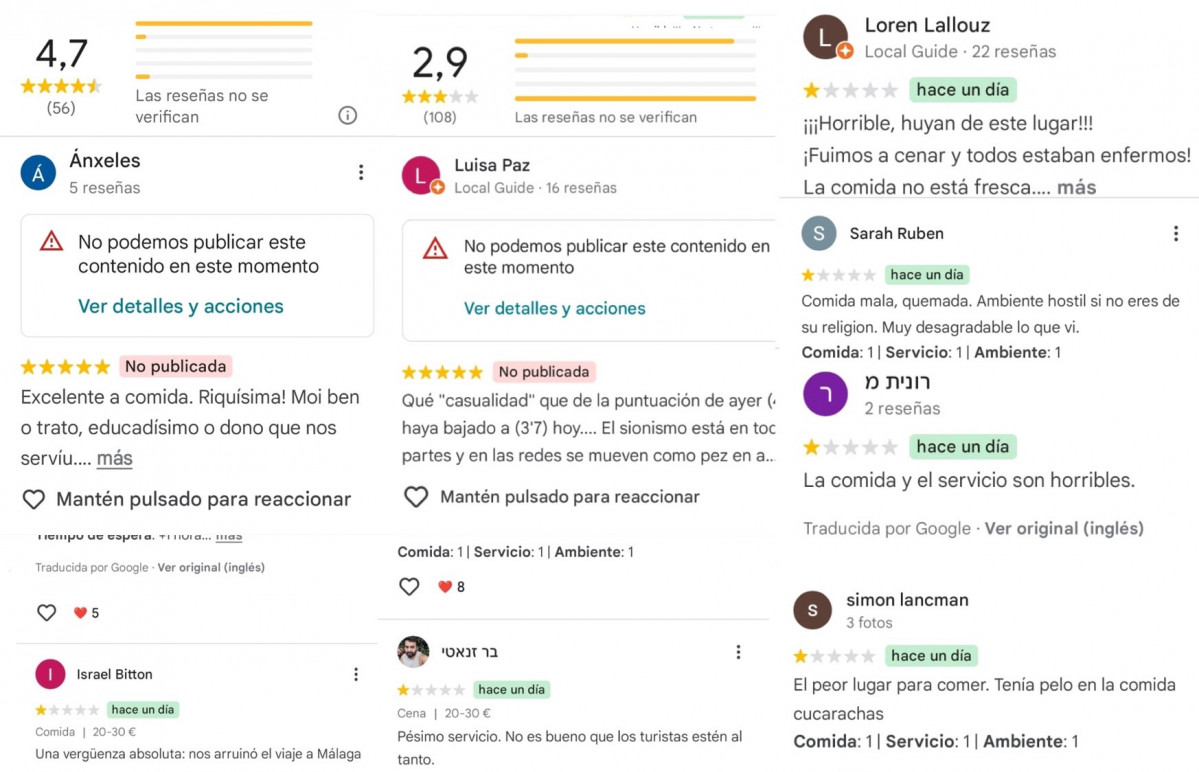

En cuestión de días, la calificación media del restaurante cayó abruptamente de 4,7 a 3 estrellas, y esto afectó a su visibilidad. Pero lo más llamativo no fue solo la caída, sino la invisibilización sistemática de cientos de reseñas positivas publicadas en su defensa. A día de hoy, Google ha bloqueado de facto cualquier intento de equilibrar la balanza.

Google Maps utiliza sofisticados sistemas automatizados para detectar reseñas falsas, spam o contenido ofensivo. Estos algoritmos analizan el lenguaje, el origen de la cuenta, el patrón de publicaciones y otros factores técnicos para decidir qué reseñas se publican y cuáles no.

En situaciones sensibles, Google aplica políticas más estrictas para evitar la manipulación de la opinión pública. Sin embargo, estos filtros se han vuelto en contra de quienes intentan expresar mensajes legítimos de apoyo o solidaridad.

En el caso de Mimassa, la mayoría de las reseñas que expresaban apoyo al mensaje humanitario del propietario fueron bloqueadas o eliminadas porque contenían palabras clave como “infancia”, “paz”, “víctimas civiles” o “humanidad”, expresiones como "Palestina libre", referencias al "genocidio en Gaza" o menciones explícitas al sionismo como ideología política.

Estos términos fueron identificados por el sistema como “contenido sensible” o ajenos al contexto gastronómico, y su publicación fue censurada por considerarse contenido político o no relevante para el servicio prestado.

Como contraste, las críticas negativas, que presentaban indicios claros de campañas organizadas y perfiles sospechosos, lograron superar los filtros gracias a un lenguaje más “neutral”, la ausencia de términos que activen los mecanismos de bloqueo o su apariencia de reseñas “verificables”.

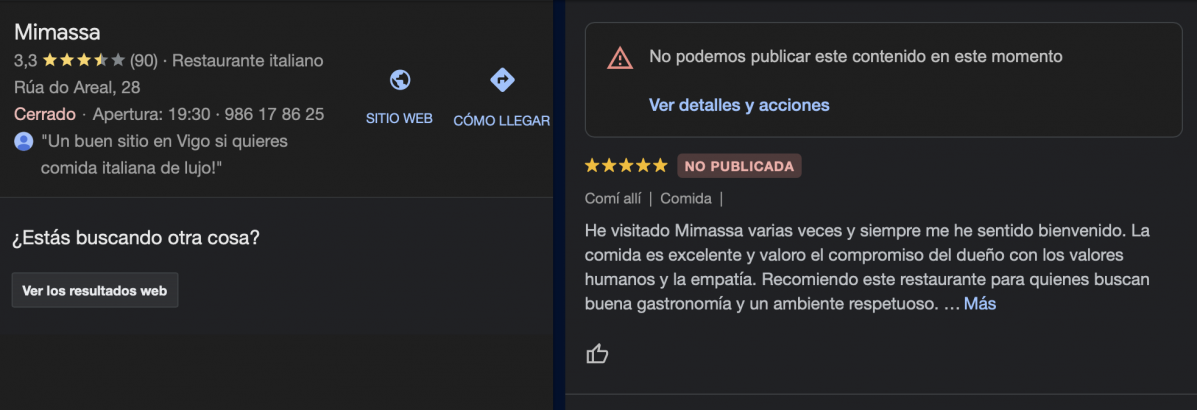

Desde que se viralizase el vídeo de Samir, esta asimetría -convertida en castigo algorítmico- ha provocado que sea imposible publicar reseñas positivas sobre el restaurante. Cualquier intento ha sido rechazado por el sistema de Google. Por ejemplo, la siguiente reseña, redactada con cuidado para cumplir todas las políticas de Google, no ha sido publicada:

“He visitado Mimassa varias veces y siempre me he sentido bienvenido. La comida es excelente y valoro el compromiso del dueño con los valores humanos y la empatía. Recomiendo este restaurante para quienes buscan buena gastronomía y un ambiente respetuoso.”

Este testimonio cumple con todos los requisitos que Google establece para las contribuciones: está basado en una experiencia real, es relevante para el negocio, respetuosa y constructiva. Sin embargo, el algoritmo la marcó para revisión o la bloqueó, e impidió que el apoyo se hiciera visible.

Los sistemas de moderación automatizada de Google se basan en algoritmos que detectan patrones y palabras clave, pero carecen de capacidad para entender el contexto ético y humano. El problema reside en la rigidez de los filtros, que no pueden entender el contexto, el tono ni la ética detrás de una publicación.

Así, mientras el sistema detecta y bloquea mensajes como “Defender la infancia no es antisemitismo”, permite que reseñas sospechosas de perfiles nuevos hundan la reputación de un negocio sin consecuencias. Entre las causas posibles:

Esto provoca que, en ocasiones, mensajes positivos sobre valores universales como la humanidad y la defensa de la infancia sean considerados “contenido sensible” o “manipulación”, y que las críticas negativas —aunque infrinjan las normas— pasen los filtros por utilizar un lenguaje “neutral” o “técnico”.

Google tiene políticas estrictas para garantizar que las reseñas sean útiles, relevantes y respetuosas. Pero en este caso, muchas de las críticas negativas visibles parecen violar esas políticas y, sin embargo, permanecen activas aunque incluyan:

A pesar de todo lo expuesto, estas reseñas permanecen visibles, mientras que las positivas que cumplen las reglas son bloqueadas o retenidas por el sistema automático. ¿Quá hacer entonces?

No hay evidencia pública de que Google favorezca deliberadamente un discurso sobre otro, pero los algoritmos pueden incorporar sesgos inadvertidos.

Estudios independientes sobre la IA de Google para detectar “lenguaje de odio” (la API Perspective) han mostrado que un filtro automático de Google podría confundir giros lingüísticos o referencias culturales de un grupo (por ejemplo, insultos en otro idioma) con discurso de odio, mientras pasa por alto contenidos similares en otro contexto.

Para sortear estos sesgos, se aconseja a quienes deseen dejar reseñas positivas:

No es la primera vez que Google se ve forzado a intervenir en su sistema de reseñas por un conflicto político. Durante el comienzo de la guerra en Ucrania, en 2022, la plataforma bloqueó la publicación de nuevas reseñas en negocios rusos ante una oleada de opiniones falsas relacionadas con la invasión.

En octubre de 2023, tras los ataques de Hamas en los territorios ocupados por Israel, Google bloqueó temporalmente las reseñas en Gaza y Cisjordania, así como en otras zonas específicas.

En España, varios restaurantes catalanes sufrieron boicots digitales por expresar apoyo al independentismo. El restaurante Semproniana de Barcelona, por ejemplo, fue atacado en Google, Facebook y TripAdvisor con puntuaciones falsas por haber organizado una cena solidaria con presos políticos.

El caso del restaurante Mimassa pone sobre la mesa una cuestión crítica para la era digital: ¿hasta qué punto los algoritmos deben tener la última palabra en la gestión de la opinión pública? ¿Cómo garantizar que la moderación automática no se convierta en un instrumento de censura indirecta, especialmente en causas éticas universales como la defensa de la infancia y la humanidad?

Mientras el mundo busca mayor justicia social, también debe repensar cómo las plataformas tecnológicas equilibran la libertad de expresión, la protección frente al abuso y el respeto a los valores humanos fundamentales.