La privacidad de los usuarios de ChatGPT ha vuelto al centro del debate tras conocerse que miles de conversaciones mantenidas con la inteligencia artificial de OpenAI aparecieron indexadas en resultados de búsqueda de Google.

Lo que muchos consideraban una herramienta para compartir chats de forma controlada resultó ser una vía de exposición pública de información sensible, como datos personales, consultas médicas, problemas emocionales o estrategias profesionales.

Esta brecha ha causado una fuerte reacción entre la comunidad tecnológica y los usuarios habituales de la plataforma, al descubrir que bastaba con un simple clic –y una casilla marcada– para que sus mensajes quedaran disponibles en internet.

Aunque OpenAI ya ha retirado la función implicada y trabaja para eliminar los contenidos afectados, el incidente revela fallos en la forma en que se comunica el alcance de estas funciones “opt-in” y plantea preguntas urgentes sobre la protección de datos en herramientas basadas en inteligencia artificial.

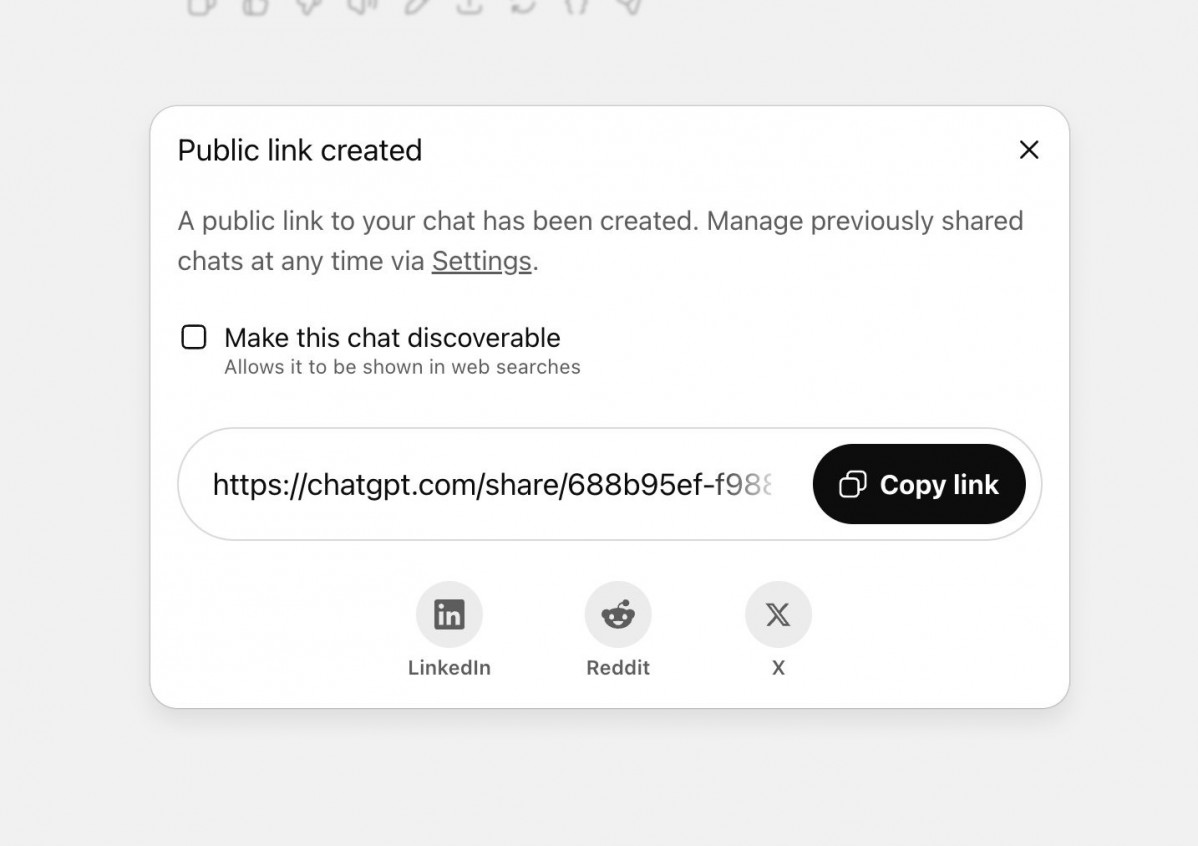

OpenAI lanzó una herramienta que permitía generar un enlace público desde una conversación de ChatGPT. Los usuarios debían aceptar explícitamente dos pasos: pulsar Share y marcar una casilla llamada “Make this chat discoverable”. Esa acción autorizaba que los motores de búsqueda, incluido Google, indexaran la conversación.

Fast Company reveló que aparecían más de 4.500 chats indexados, incluyendo conversaciones sobre salud mental, relaciones, empleo o incluso datos identificativos como direcciones y correos electrónicos (Tom's Guide). Aunque OpenAI anonimiza los enlaces, el contenido muchas veces incluye detalles sensibles que pueden ser rastreables (Cybernews).

La confusión surgió porque muchos usuarios no leyeron las advertencias y marcaron la casilla sin percatarse de su alcance. Para algunos, compartir era simplemente guardar un chat o reenviarlo por WhatsApp, sin imaginar que sería público.

Una experta en ética de IA de la Universidad de Oxford, Carissa Veliz, declaró a Fast Company estar “atónita” al descubrir que Google había registrado conversaciones “extremadamente sensibles”.

Algunos usuarios expresaron su indignación en Reddit: “al hacer clic en 'compartir', se les presentaba la opción de marcar la casilla 'Hacer que este chat sea visible'. Debajo de eso..., había una advertencia que explicaba que el chat podría aparecer en los resultados de búsqueda.”

Ante la repercusión, OpenAI respondió rápidamente. Su director de seguridad, Dane Stuckey, anunció que se eliminó la función y se trabaja con Google y otros motores para retirar el contenido previamente indexado. OpenAI afirmó que fue un “experimento breve” que generó demasiadas posibilidades de exposición accidental.

Si alguien creó uno de estos enlaces públicos, puede eliminarlo en la configuración de ChatGPT (sección Data Controls > Shared Links) o borrar los enlaces de forma individual o todos a la vez. Aunque se elimine el chat o el enlace, es posible que persista en los resultados de búsqueda durante varias horas o días hasta que Google actualice su índice. En ese caso se recomienda utilizar la herramienta de Google (Google Remove tool) para eliminar contenido obsoleto.

Este incidente subraya la importancia de la transparencia en las funciones de IA y la necesidad de que los usuarios comprendan claramente las implicaciones antes de compartir contenido.

Queda demostrado que, incluso mecanismos opt‑in, pueden causar graves riesgos si no se comunican con claridad. También pone de relieve la necesidad de tratar las conversaciones generadas por IA como información confidencial, similar a correos electrónicos o documentos personales.